Si bien la IA ofrece un sinfín de nuevas oportunidades, también introduce una gran variedad de nuevas amenazas. La IA generativa permite a los actores maliciosos crear deepfakes y sitios web falsos, enviar spam e incluso hacerse pasar por tus amigos y familiares. En esta publicación, se explica cómo se utilizan las redes neuronales para las estafas y el phishing. También te compartiremos consejos sobre cómo mantenerte a salvo. Para obtener información más detallada sobre las estafas de phishing con tecnología de IA, consulta el informe completo en Securelist.

Matanza de cerdos, catfishing y deepfakes

Los estafadores están usando bots con IA que se hacen pasar por personas reales, especialmente en las estafas románticas. Crean personalidades ficticias que las usan para comunicarse con varias víctimas al mismo tiempo y establecer fuertes vínculos emocionales. Esto puede prolongarse durante semanas o incluso meses: primero comienza con un ligero coqueteo y, luego, se pasa gradualmente a tener conversaciones sobre “oportunidades de inversión lucrativas”. La conexión personal a largo plazo ayuda a disipar cualquier sospecha que pueda tener la víctima. Pero la estafa, por supuesto, termina una vez que la víctima invierte su dinero en un proyecto fraudulento. Este tipo de estafas se conocen como “matanza de cerdos”, que ya tratamos en detalle en una publicación anterior. Si bien antes eran administradas por enormes granjas de estafas en el sudeste asiático que empleaban a miles de personas, estas estafas ahora dependen cada vez más de la IA.

Las redes neuronales han facilitado mucho el catfishing, es decir, los estafadores crean una identidad falsa o se hacen pasar por una persona real. Las redes neuronales generativas modernas pueden imitar la apariencia, la voz o el estilo de escritura de una persona con un grado de exactitud suficiente. Lo único que tiene que hacer un estafador es recolectar la información pública sobre una persona e introducir esos datos en la IA. Y absolutamente todo puede ser de utilidad: fotografías, vídeos, publicaciones y comentarios públicos, información sobre familiares, pasatiempos, edad, etc.

Por lo tanto, si un familiar o amigo te envía un mensaje desde una cuenta nueva y, por ejemplo, te pide que le prestes dinero, es probable que no sea realmente tu familiar o amigo. En una situación como esa, lo mejor que puedes hacer es contactar con la persona real a través de otro canal (por ejemplo, llamándola por teléfono) y preguntarle directamente si todo está bien. Otra medida inteligente es hacer algunas preguntas personales que un estafador no podría encontrar en Internet ni en tus mensajes anteriores.

Pero la suplantación de identidad mediante textos convincentes es solo una parte del problema: los deepfakes de audio y vídeo representan una amenaza aún mayor. Hace poco compartimos cómo los estafadores utilizan deepfakes de blogueros populares e inversores en criptomonedas en las redes sociales. Estas celebridades falsas invitan a sus seguidores a tener “consultas personales” o unirse a “chats exclusivos sobre inversiones”, o incluso prometen premios en efectivo y regalos costosos.

Sin embargo, las redes sociales no son el único lugar donde se usan los deepfakes. También se generan para videollamadas y llamadas de audio en tiempo real. A principios de este año, una mujer de Florida perdió 15 000 $ después de creer que estaba hablando con su hija, que supuestamente había sufrido un accidente de coche. Los estafadores utilizaron un deepfake muy realista de la voz de su hija e incluso lograron imitar su llanto.

Los expertos del equipo GReAT de Kaspersky encontraron ofertas en la dark web para crear deepfakes de vídeo y audio en tiempo real. El precio de estos servicios depende de la sofisticación y la duración del contenido: puede costar tan solo 30 $ para los deepfakes de voz y 50 $ para los vídeos. Hace solo un par de años, estos servicios costaban mucho más (hasta 20 000 $ por minuto) y la generación de contenido en tiempo real no existía.

Los anuncios ofrecen diferentes opciones: intercambio de rostros en tiempo real en videoconferencias o aplicaciones de mensajería, intercambio de rostros para la verificación de identidad o sustitución de imagen de un teléfono o una cámara virtual.

Los estafadores también ofrecen herramientas para sincronizar los labios con cualquier texto en un vídeo, incluso en idiomas extranjeros. Además, ofrecen herramientas de clonación de voz que pueden cambiar el tono y el timbre para adaptarse a la emoción deseada.

Sin embargo, nuestros expertos sospechan que muchos de estos anuncios de la dark web podrían ser estafas en sí mismas, que están diseñadas para engañar a otros posibles estafadores para que paguen por servicios que en realidad no existen.

Cómo mantenerse seguro

- No confíes en tus conocidos en línea a los que nunca hayas visto en persona. Aunque hayas estado chateando con ellos durante un tiempo y sientas que has encontrado a un “alma gemela”, desconfía si te hablan de criptomonedas, inversiones o cualquier otro plan que requiera que les envíes dinero.

- No te dejes engañar si te encuentras con ofertas inesperadas y atractivas que aparentemente provienen de celebridades o empresas grandes en las redes sociales. Consulta siempre sus cuentas oficiales para verificar la información. No continúes si, para darte un “regalo”, en algún momento te piden que pagues una tarifa, impuestos o gastos de envío, o que introduzcas los datos de tu tarjeta de crédito para recibir un premio en efectivo.

- Si tus amigos o familiares te envían mensajes con peticiones inusuales, ponte en contacto con ellos a través de otro canal, como el teléfono. Para mayor seguridad, pregúntales por algo de lo que hayas hablado en su última conversación en persona. En el caso de amigos cercanos y familiares, es una buena idea acordar de antemano una palabra clave que solo vosotros conozcáis. Si comparten su ubicación, compruébala y confirma dónde se encuentra la persona. Y no caigas en la trampa de la manipulación para “apresurarte”: el estafador o la IA pueden decirte que la situación es urgente y que no tienen tiempo para responder preguntas “tontas”.

- Si tienes dudas durante una videollamada, pídele a la persona que gire la cabeza hacia un lado o que haga un movimiento complicado con la mano. Por lo general, los deepfakes no pueden cumplir con estas peticiones sin romper la ilusión. Además, si la persona no parpadea o sus movimientos labiales o expresiones faciales parecen extraños, es otra señal de alarma.

- Nunca reveles ni compartas números de tarjetas bancarias, códigos de un solo uso ni ninguna otra información confidencial.

Un ejemplo de un deepfake que se desintegra cuando gira la cabeza. Fuente.

Llamadas automatizadas

Se trata de una forma eficaz de engañar a las personas sin tener que hablar con ellas directamente. Los estafadores están usando la IA para realizar llamadas automatizadas falsas en nombre de bancos, operadores de telefonía móvil y servicios gubernamentales. Al otro lado de la línea, solo hay un bot que se hace pasar por un agente de soporte. Parece real porque muchas empresas legítimas utilizan asistentes de voz automatizados. Sin embargo, una empresa real nunca te llamará para decirte que tu cuenta ha sido hackeada ni te pedirá un código de verificación.

Si recibes una llamada de este tipo, lo importante es que mantengas la calma. No te dejes engañar por tácticas intimidatorias en las que se menciona “una cuenta hackeada” o “dinero robado”. Simplemente cuelga y usa el número oficial que aparece en el sitio web para llamar a la empresa real. Ten en cuenta que las estafas modernas pueden involucrar a varias personas que te van derivando de una a otra. Pueden llamar o enviar mensajes de texto desde números diferentes y fingir que son empleados bancarios, funcionarios del gobierno o incluso policías.

Chatbots y agentes de IA susceptibles al phishing

Hoy en día, muchas personas prefieren recurrir a los chatbots como ChatGPT o Gemini en lugar de los motores de búsqueda habituales. Pero ¿cuáles serían los riesgos? Bueno, los modelos de lenguaje grandes se entrenan con datos de los usuarios. Y se sabe que los chatbots más populares sugieren sitios de phishing a los usuarios. Cuando realizan búsquedas en la web, los agentes de IA se conectan a motores de búsqueda que también pueden contener enlaces de phishing.

En un experimento reciente, los investigadores lograron engañar al agente de IA del navegador Comet de Perplexity con un correo electrónico falso. El correo electrónico supuestamente procedía de un administrador de inversiones de Wells Fargo, uno de los bancos más grandes del mundo. Los investigadores enviaron el correo electrónico desde una cuenta de Proton Mail recién creada. Incluía un enlace a una página de phishing real que llevaba varios días activa, pero que la Navegación segura de Google aún no había marcado como maliciosa. Cuando se revisó la bandeja de entrada del usuario, el agente de IA marcó el mensaje como “tarea pendiente del banco”. Sin haber hecho más comprobaciones, siguió el enlace de phishing, abrió la página de inicio de sesión falsa y, luego, le pidió al usuario que introdujera sus credenciales. ¡Hasta le ayudó a completar el formulario! Básicamente, la IA avaló la página de phishing. El usuario nunca vio la dirección de correo electrónico sospechosa del remitente ni el enlace de phishing en sí. En su lugar, fue redirigido inmediatamente a una página de introducción de contraseña que le había proporcionado este “servicial” asistente de IA.

En el mismo experimento, los investigadores usaron una plataforma de desarrollo web con tecnología de IA llamada Loveable para crear un sitio web falso que imitaba a una tienda Walmart. Después, visitaron el sitio en Comet, que es algo que un usuario desprevenido podría hacer fácilmente si se dejara engañar por un enlace o un anuncio de phishing. Le pidieron al agente de IA que comprara un Apple Watch. El agente analizó el sitio falso, encontró una oferta que era una “ganga”, añadió el reloj al carrito, introdujo la dirección y la información de la tarjeta bancaria almacenada en el navegador y completó la “compra” sin pedir ninguna confirmación. Si se hubiera tratado de un sitio fraudulento real, el usuario habría perdido una buena cantidad de dinero a la vez que entregaba sus datos bancarios en bandeja de plata a los estafadores.

Por desgracia, los agentes de IA se comportan actualmente como novatos ingenuos en la web, por lo que caen fácilmente en la ingeniería social. Anteriormente, ya hemos analizado en detalle los riesgos de integrar la IA en los navegadores y cómo minimizarlos. Pero, como recordatorio, para evitar convertirte en la próxima víctima de un asistente demasiado confiado, debes evaluar de forma crítica la información que te proporciona, limitar los permisos que concedes a los agentes de IA e instalar una solución de seguridad fiable que bloquee el acceso a sitios maliciosos.

Sitios web de phishing generados por IA

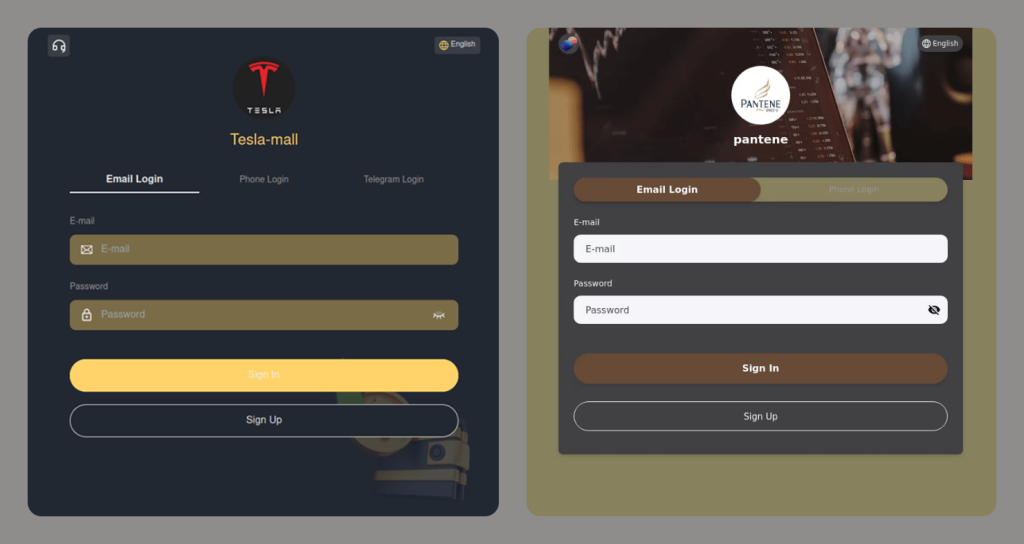

Los días de los sitios de phishing incompletos, mal diseñados y llenos de anuncios indiscretos han quedado atrás. Los estafadores modernos se esfuerzan por crear falsificaciones realistas que utilizan el protocolo HTTPS, muestran acuerdos de usuario y avisos de consentimiento de cookies, y tienen diseños razonablemente buenos. Las herramientas con tecnología de IA han hecho que la creación de este tipo de sitios web sea mucho más barata y rápida, por no decir que es casi instantánea. Es posible encontrar un enlace a uno de estos sitios en cualquier lugar: en un mensaje de texto, en un correo electrónico, en las redes sociales o incluso en los resultados de búsqueda.

Cómo detectar un sitio de phishing

- Comprueba si hay errores de escritura en la URL, el título y el contenido.

- Averigua cuánto tiempo lleva registrado el dominio del sitio web. Puedes comprobarlo aquí.

- Presta atención al lenguaje que se usa. ¿El sitio intenta asustarte o acusarte de algo? ¿Intenta atraerte o presionarte para que actúes? Cualquier manipulación emocional es una gran señal de alarma.

- Activa la función de comprobación de enlaces en cualquiera de nuestras soluciones de seguridad.

- Si tu navegador te advierte de una conexión no segura, abandona el sitio. Los sitios legítimos usan el protocolo HTTPS.

- Busca el nombre del sitio web en línea y compara la URL que tienes con la que aparece en los resultados de búsqueda. Ten cuidado, ya que es posible que los motores de búsqueda muestren enlaces de phishing patrocinados en la parte superior de la página. Asegúrate de que no haya ninguna etiqueta que diga “Anuncio” o “Patrocinado” junto al enlace.

Obtén más información sobre cómo usar la IA de forma segura:

- Cómo las redes sociales de Meta se convirtieron en una plataforma para estafas de inversión

- Te espera un gran pago de nuevo

- Troyanos que se hacen pasar por clientes de DeepSeek y Grok

- Cómo los estafadores eluden la verificación de identidad del cliente mediante deepfakes

- Deepfakes de voz: no creas todo lo que escuchas

phishing

phishing

Consejos

Consejos